Revisión Sistemática y Metaanálisis

Introducción

La Colaboración Cochrane define la revisión sistemática como una síntesis de los resultados de varios estudios primarios mediante técnicas que limitan los sesgos y el error aleatorio. La unidad de investigación no es un individuo o un paciente, sino el estudio. Es un conjunto de técnicas que se utilizan para cuantificar la información contenida en estudios similares que valoran un mismo asunto. El concepto de metaanálisis fue previo al de revisión sistemática. En la actualidad, el término metaanálisis se reserva para denominar el conjunto de técnicas estadísticas de combinación de resultados, mientras que en el pasado incluía también la noción de revisión sistemática. Ante la abundancia de información existente, muchas veces con resultados contradictorios, surge como una técnica eficiente y reproducible.

Los últimos hallazgos sólo tienen sentido cuando se comparan con los previos; para que la ciencia se acumule se necesita un escalón entre el pasado y el futuro, la «revisión». Ésta cumple una función de iniciación al estudio de un tema y tiene una indiscutible utilidad en la enseñanza. Sin embargo, tiene varios defectos:

- su subjetividad, ya que el proceso de revisión carece de cualquier regla formal (no es sistemático);

- no tiene carácter científico, por la ausencia de metodología para integrar resultados contradictorios, y

- es un camino poco eficaz en la extracción de información útil, sobre todo cuando hay muchos estudios originales.

La forma de obviar estos inconvenientes es la utilización de un método que permita combinar resultados procedentes de varios estudios. Ésta es la razón de ser de la revisión sistemática. Su necesidad surge ante la cantidad ingente de información existente sobre cualquier tema.

La idea de combinar los resultados de estudios pequeños para llegar a conclusiones más firmes no es reciente. En 1904, Karl Pearson agrupó datos de instalaciones militares de Sudáfrica y la India y concluyó que la vacunación contra la fiebre intestinal no era tan eficaz como para recomendar su uso. Joseph Goldberger, el investigador de la pelagra, publicó en 1907 una síntesis de la frecuencia de infección urinaria en la fiebre tifoidea; de 44 estudios seleccionó 26 por la idoneidad del método diagnóstico y los promedió. Pero no fue hasta los años setenta cuando se empezaron a realizar metaanálisis en gran escala, y se evaluaron los efectos del programa Gran Sociedad del presidente Johnson. El término metaanálisis lo acuñó el psicólogo Gene Glass, en 1976, para describir la interpretación estadística de datos procedentes de varias experiencias similares.

Los objetivos del metaanálisis son los siguientes:

- Valoración de la consistencia (o heterogeneidad) entre diferentes estudios que analizan las mismas variables.

- Obtención de un mejor estimador global de la relación entre las variables que se analizan.

- Identificación de subgrupos que son particularmente susceptibles a la variable exposición que se estudia.

- Valoración de la calidad de la metodología empleada en cada una de las investigaciones individuales y, tras el análisis de la consistencia entre los distintos resultados, ofrecer un esquema de la metodología que habrá que seguir en futuros estudios.

De estos objetivos se derivan fácilmente sus utilidades, tanto en el campo del estudio de los factores de riesgo como en el análisis de tratamientos, pruebas diagnósticas y estudio de factores pronósticos.

Protocolo

El esquema general de diseño de una revisión sistemática es el siguiente:

- Una hipótesis de trabajo.

- Selección de la población de estudio:

- Fuentes de información: bases informatizadas, búsqueda manual en repertorios, contacto con los autores de los estudios, etc.

- Criterios de búsqueda de la información en repertorios con indicación expresa de las palabras clave utilizadas.

- Criterios de inclusión de una investigación: idioma, tipo de diseño, exposición y efecto que se investiga, etc.

- Recogida de datos: valoración de la validez de los estudios primarios. Extracción de la información relevante de cada estudio.

- Metaanálisis:

- Métodos estadísticos empleados para la combinación de resultados.

- Metodología empleada para tratar el problema de la heterogeneidad.

- Valoración estadística del sesgo de publicación.

Origen de la hipótesis

Antes de enumerar los distintos estudios que podrán ser incluidos en el metaanálisis debe existir una hipótesis que guíe la recogida de información. Debería dejarse claro si, por el contrario, se intenta explorar el conocimiento existente sobre una asociación. En el primer caso, el análisis de la información disponible intenta comprobar una idea previamente elaborada. En el segundo sucede lo opuesto, y con frecuencia se elabora una hipótesis que justifique los resultados del análisis. En este caso no se puede concluir nada, ya que no es científico utilizar los mismos datos que sugieren una hipótesis para corroborarla; aquí, dado que se va a utilizar toda la información disponible, una estrategia sensata sería utilizar la mitad de los estudios para generar una hipótesis y el resto, para confirmarla.

Selección de la población de estudio

Búsqueda de la información

Dentro de un estudio epidemiológico convencional, esta búsqueda equivale a la selección de la población de estudio. La población de referencia en una revisión sistemática está configurada por todos los estudios realizados sobre un tema concreto. Existen varias opciones:

- Buscar toda la información disponible, publicada y no publicada (más difícil de localizar). Para aproximarse a ella pueden buscarse las tesinas de licenciatura y tesis doctorales, las becas concedidas y solicitadas, los contratos de investigación, las actas de congresos y el contacto con especialistas en el tema. El problema es encontrar bases de datos que contengan esta información con una perspectiva internacional. En los ensayos clínicos, la Colaboración Cochrane hace un esfuerzo en diferentes países (incluyendo España) para mantener un registro de todos los ensayos clínicos en curso, con independencia de que luego se publiquen. De todas formas, ninguna de las opciones mencionadas garantiza la exhaustividad en la identificación.

La principal desventaja de esta estrategia radica en el tiempo y dinero necesarios para localizar toda esta información. También la calidad de los estudios puede ser muy variable, no siendo la misma la de los informes no publicados que la de los publicados. Frente a estos inconvenientes, presenta la ventaja de que intenta evitar el sesgo de publicación. - Lo más frecuente es utilizar sólo estudios publicados, ahorra tiempo y dinero con respecto a la opción anterior. Presenta el problema del sesgo de publicación: los estudios publicados no tienen por qué representar al total de los realizados.

- Utilizar las bases originales de datos de los estudios que se combinan. El primer estudio de este tipo se publicó en 1990: 12 grupos de investigación se unieron para examinar la hipótesis de dieta y cáncer de mama a través de sus 12 estudios de casos y controles. No fue exhaustivo, ya que hasta ese momento existían muchos más estudios que habían analizado la mencionada asociación. Las ventajas de la combinación de bases de datos son obvias:

- permite el análisis de exposiciones raras, y

- pueden examinarse mejor las relaciones de confusión e interacción.

No obstante, también tiene algunos inconvenientes: - es menos factible que otras estrategias, ya que las bases de datos han de existir y sus autores deben ser proclives a permitir su uso (mayor posibilidad de sesgo de selección), y

- requiere más tiempo: puesta en contacto con los autores, explicación de objetivos, etc.

Cuando se combinan bases de datos, es preceptivo el análisis de la heterogeneidad debido a las distintas peculiaridades metodológicas y poblacionales de cada estudio.

Métodos de búsqueda de información

Pueden utilizarse los siguientes:

- Uso de repertorios informatizados; el más usado es MEDLINE. Tiene el inconveniente del sesgo hacia las revistas anglosajonas, el 55% del total. La consulta de otros repertorios, también en CD-ROM, según los temas, es conveniente. MEDLINE sólo cubre menos del 20% del total de publicaciones. Otras bases de datos que pueden consultarse son: EMBASE (Excerpta Medica, desde 1974), CANCERLIT-ONCODISK (Oncología, desde 1985), etc. Las estrategias de búsqueda no deberían confiar excesivamente en las palabras clave.

Sería de ayuda el que también se buscara por sinónimos en las opciones de búsqueda libre. El principal inconveniente del uso de repertorios es que no son exhaustivos de todas las revistas que existen y que no incluyen textos; no es infrecuente que aparezca un estudio original publicado en un libro. Según los estándares actuales, se requiere consultar al menos dos bases de datos. - Consulta de la bibliografía de cada uno de los artículos localizados, lo cual siempre debe hacerse. Con ello se tienen en cuenta las revisiones hechas por los demás autores que han investigado en el tema. Esto facilita la localización de artículos e informes publicados en revistas no recogidas en los repertorios de consulta y también los aparecidos en libros.

- Consulta con investigadores que hayan estudiado el problema; puede ayudar a la identificación de informes y estudios no publicados. Presenta el inconveniente de que la información proporcionada puede ser subjetiva.

- Revisión de los índices de las revistas; los artículos centrados en un tema se suelen publicar en un rango limitado de revistas. Esta estrategia es recomendable si el tema que debe investigarse está mal indexado (no hay palabras clave adecuadas).

- Otras fuentes: ya mencionadas cuando la estrategia general es identificar los estudios no publicados.

Sesgo de publicación

Debido a las dificultades enumeradas con anterioridad, lo más frecuente es que los investigadores se basen en estudios ya publicados, más fáciles de localizar. El sesgo de publicación se origina cuando lo que se publica no es representativo de lo que se investiga. La trascendencia de este sesgo es grande: si lo que aparece no representa la realidad, se está distorsionando el propio proceso de aprendizaje. Es por ello que resulta de gran importancia saber si este sesgo se presenta y cuáles son las razones que favorecen su presencia (tabla 17-1).

Tabla 17-1. Causas del sesgo de selección en el metaanálisis:

- Imposibilidad de enumerar la población de referencia

- Sesgo de publicación

- Por resultados significativos

- Tipo de diseño

- Idioma

- Conflicto de intereses

- Tipo y existencia de financiación

- Tamaño de la muestra

- Prestigio institucional

- Prejuicio

- Regresión a la media

- Sesgos en la redacción/evaluación

- De retórica

- Todo está claro

- Citación de lo favorable

- Temas en el candelero

La razón más importante es la existencia de resultados estadísticamente significativos, algo que se documentó por primera vez en 1959. Esta tendencia se encuentra en los autores y en los revisores. Los resultados significativos suelen ser los primeros en publicarse, lo cual tiene importancia pues justifica que el entusiasmo inicial por una prueba diagnóstica o por un tratamiento se enfríe con el tiempo.

Varios estudios han investigado dónde radica el problema de publicación, si en el autor o en el proceso editorial. Es interesante comprobar que con mayor frecuencia es el propio autor el que no decide enviar sus resultados para que sean publicados. Se argumentan varias razones, entre las cuales destaca la falta de interés de los resultados, y en esto está inmanente la ausencia de significación estadística. Otra de las razones que se aducen con cierta frecuencia es no tener la propiedad de los datos, ya que ciertos resultados permanecen ocultos por intereses privados. También son razones para no publicar los problemas de diseño o ejecución de un estudio que impidieron la obtención de resultados válidos, la falta de novedad de los resultados (en el caso de tratamientos, por mantenerse vigente el tratamiento clásico frente al innovador), etc. Menos de un 10% de los autores han argumentado que la razón para no publicar fue el rechazo por parte de los editores.

Algunas características de la investigación realizada se asocian con una probabilidad diferencial de publicación: los estudios aleatorizados y los multicéntricos se han asociado con una mayor frecuencia de publicación. El tamaño de muestra es un determinante de publicación. Los estudios grandes suponen un mayor esfuerzo en su diseño y ejecución, y los autores ponen un mayor interés en que los resultados no permanezcan ignorados, ya sean positivos o negativos. La fuente de financiación se asocia con la publicación.

En principio hay que pensar que los estudios financiados por organismos públicos —no así los privados— tienen más probabilidades de publicarse que los no financiados, ya que es una forma de dejar constancia de que los fondos empleados han llegado a algún fin. El conflicto de interés puede dar lugar a publicaciones engañosas o maquilladas y puede dar pie a que cierto tipo de documentación tenga más probabilidad de ser publicada. Un ejemplo de ello es el de la industria tabaquera con los efectos del tabaquismo pasivo.

El prestigio de la institución puede desempeñar un papel en el sesgo de publicación. Ciertos centros gozan de prestigio en determinados campos y el evaluador puede conocer la procedencia de un estudio. Es posible que en caso de una información incompleta se asuma la corrección si se sabe que la institución ejecutora es afamada o se planteen dudas si el centro no goza de prestigio. Un ejemplo histórico de esto es el artículo de Morton Levin sobre la asociación tabaco-cáncer de pulmón, retenido por el director de JAMA ante la desconfianza surgida por lo novedoso del procedimiento (uno de los primeros estudios de casos y controles de la historia), hasta que llegó a sus manos un estudio similar (de Wynder y Graham), pero firmado por un cirujano de prestigio mundial y conocido por sus innovaciones. Publicó los dos estudios en el mismo número, pero primero el de Wynder y Graham.

El proceso editorial puede ser responsable, ya que los evaluadores de revistas son también autores. La responsabilidad editorial es máxima en los casos en los que se traslucen opiniones preconcebidas sobre un tema. Por ejemplo, en la asociación entre el consumo de cocaína durante el embarazo y los riesgos en el feto se ha comprobado que los trabajos que no han encontrado un efecto nocivo se han rechazado con más frecuencia, aunque su calidad fuera similar a los que sí encontraron un efecto pernicioso. Se juzga la calidad por las conclusiones alcanzadas.

El sesgo de publicación se ha intentado justificar parcialmente como un fenómeno de regresión a la media. La evaluación de manuscritos no es perfecta y, por lo tanto, la revisión por parte de distintos evaluadores de una misma revista mantiene un coeficiente de correlación bajo. Los artículos seleccionados inicialmente por parte de una revista no resultan tan excelentes en revisiones ulteriores.

Control del sesgo de publicación

Los editores deben vigilar el proceso de revisión de los manuscritos recibidos. Existen algunas dudas acerca sobre si el proceso de evaluación debe ser anónimo o abierto, cada uno con sus ventajas e inconvenientes. Se prefiere la evaluación enmascarada. El limitarse a cuestionarios estructurados en el proceso de evaluación facilita la valoración y la hace más reproducible, pero limita la expresividad de los autores y no todos los aspectos de un estudio pueden contemplarse en un listado de preguntas. Deberían hacerse esfuerzos para que toda investigación con un mínimo de calidad se publicara, con independencia de la significación de sus resultados. Ya hay revistas electrónicas que publican sin preocuparse por la longitud del texto (como BioMed Central).

El registro de investigaciones, como la base de ensayos perinatales de Oxford o la Colaboración Cochrane, que intenta monitorizar todo ensayo clínico en marcha, tiene sus limitaciones. Puede haber un conflicto de intereses, por ejemplo, si la fuente de financiación privada prefiere que no se sepa que una investigación está en marcha, algo que no es infrecuente en salud laboral o cuando se esperan grandes beneficios económicos en el desarrollo de nuevos preparados farmacológicos. No obstante, también hay ventajas: valorar el sesgo de publicación, defender los derechos en ser el primero en investigar un tema, conocer otros investigadores que trabajan en temas relacionados, etc.

Criterios de inclusión

Es preciso que se establezcan sin conocer los resultados de los distintos estudios. Así se minimiza el sesgo de selección. Los estudios reunidos a través de la búsqueda constituyen la serie inicial de investigaciones participantes. No todos ellos serán incluidos en el análisis. Es necesario determinar, mediante una serie de criterios de inclusión, los que permanecerán y los que serán desechados.

- Idioma. Es muy frecuente restringir el idioma, ya que resulta imposible que un grupo los domine todos. Sería aceptable si la finalidad fuera, por ejemplo, la valoración metodológica de un determinado tópico en un cierto ámbito, como un análisis de la calidad de los estudios coste-eficacia y coste-beneficio en las revistas científicas publicadas en inglés o castellano. Pero es más discutible la validez externa de metaanálisis sobre asociaciones de causalidad basadas sólo en la bibliografía inglesa, como es el caso de los estudios sobre cáncer de vejiga e ingesta de café. La calidad superior de las investigaciones en inglés no es un argumento válido a priori. Es más, en el caso de los ensayos clínicos, una investigación reciente ha comprobado que las publicaciones en español, alemán o francés no son peores que las anglosajonas. Puede haber sesgo si sólo se incluyen publicaciones en inglés. Además, se ha comprobado que los ensayos clínicos en inglés contienen con más frecuencia resultados estadísticamente significativos que los publicados en otras lenguas. Esto plantea la posibilidad de un sesgo de selección.

- Tipo de diseño. En la combinación de ensayos clínicos es habitual el que se centren sólo en los aleatorizados (mayor control de errores). En los metaanálisis de estudios de observación es frecuente que se eliminen los estudios ecológicos por el efecto impredecible de la falacia ecológica.

- Características de la exposición y del efecto. Según los objetivos de cada investigación, se han de precisar las que se desean.

- Tipo de publicación. Suele centrarse en los informes originales y se eliminan las revisiones, cartas, editoriales, etc. El problema surge cuando en una carta, por ejemplo, se encuentra información original; su extensión no suele permitir una correcta evaluación.

- Calidad. Este aspecto forma parte de la recogida de datos y se discutirá con mayor detalle en el epígrafe siguiente.

Recogida de datos

El aspecto central es la valoración de la calidad de una investigación. Las tres preguntas básicas con respecto a la valoración de la calidad son: ¿hasta qué punto importa?, ¿cómo se puede medir?, y ¿cómo incorporarla en las estimaciones de la magnitud del efecto?

Importancia de la valoración de la calidad

Los estudios de alta calidad reducen la existencia de sesgos y tienen una mayor precisión en el estimador del efecto que calculan. Un ensayo correcto con frecuencia se asocia con un mayor tamaño de muestra, y esto determina una mayor potencia estadística. Es por ello obligado hacer una valoración de la calidad de un estudio, para al menos descartar las investigaciones en las que el sesgo es más probable. Además, si la calidad de una investigación se asocia con la calidad de la revista, y existe una asociación entre ésta y el sesgo de publicación, se puede producir una asociación espuria entre la calidad de un estudio y el sesgo de publicación.

Forma de medir la calidad

Es necesaria la confección de un cuestionario de evaluación de estudios. Asimismo, debe seguirse una estrategia cuidadosa que evite el sesgo del observador, y que podría acabar en un sesgo de inclusión o de puntuación de la calidad, y que garantice la reproducibilidad intraobservador y entre observadores. A pesar de la abundante bibliografía científica sobre este error, la Colaboración Cochrane considera que un protocolo suficientemente estructurado no necesita enmascaramiento de los evaluadores.

El cuestionario debe ser aplicado por investigadores enmascarados frente a ciertas características del estudio que hay que evaluar. No se debe conocer la institución ejecutora y el nombre de los autores (su prestigio puede ejercer un cierto grado de presión), y el sentido de la asociación, ya que su conocimiento también podría influir en la selección. Es recomendable el uso del escáner para las secciones de «Métodos» y «Resultados», tachando en esta última los epígrafes indicativos de los sujetos pertenecientes a los grupos índice y de referencia. Transforma de manera fácil y rápida los formatos reconocibles de las revistas en una única forma de presentación, que facilita la estandarización en la evaluación.

Se recomienda que los evaluadores no sean los que recogen los datos de la magnitud del efecto. La familiarización con los resultados, junto a una posible opinión propia (que puede ir formándose conforme se lee), pueden contribuir a la aparición de sesgos del observador. Se considera que es suficiente que sean dos evaluadores independientes. Examinarán sus conclusiones, y si existen discrepancias, deberán intentar solucionarlas entre ellos, y si no modifican sus posturas iniciales, la decisión final la tomará un tercer investigador o consultor.

Los cuestionarios de evaluación tienen el inconveniente de su validación. No existen cuestionarios ideales para ser aplicados en toda situación. En la bibliografía científica se han publicado muchos cuestionarios para la evaluación de ensayos clínicos controlados. A pesar de ello, no existe un gran consenso en lo que constituye un ensayo clínico bueno.

La escala CONSORT en la actualidad se considera el patrón que hay que seguir. Los ítems contenidos en cada uno de estos cuestionarios no se pueden obtener de todos los estudios, lo que supone otro inconveniente. Estos cuestionarios pueden orientar para confeccionar otro para la asociación que interesa. En estudios de observación no existe ningún cuestionario maestro, ya que cada uno debe adaptarse para el problema que debe estudiarse, aunque el protocolo STROBE puede servir de guía (disponible en www.consort-statement.org). No obstante, muchos textos de epidemiología contienen las directrices básicas que hay que tener en cuenta en un diseño de observación. Los cuestionarios deben adaptarse a la hipótesis sobre la que se trabaja, con una valoración particular de los errores que amenazan a la asociación en estudio.

En la evaluación de artículos puede apreciarse una serie de errores, que pueden inducir a sesgos si la información que se va a procesar en la evaluación de artículos no se ciñe sólo a los apartados de «Métodos» y «Resultados»:

- el sesgo de retórica, al intentar convencer al lector sin tener en cuenta la razón;

- el sesgo de «todo va bien» en la bibliografía médica, cuando se omiten los resultados contradictorios o controvertidos y sólo se mencionan los resultados claros;

- el sesgo de citar lo que apoya, cuando se mencionan o resaltan los trabajos que sustentan los resultados encontrados y se omiten o desacreditan los restantes, y

- el sesgo de los temas en candelero, al publicar con premura los resultados provisionales.

Todo lo anterior se ha centrado en la evaluación de informes publicados. También se puede solicitar a los grupos de investigación originales la petición de información que no ha quedado lo suficientemente clara en la sección de «Métodos» de su estudio.

Utilidad de la calidad

El cuestionario de calidad puede tener varias funciones. En primer lugar, puede tener una función cualitativa o diferenciar si el resultado final de un estudio está probablemente sesgado o no, lo que equivale a determinar un nivel de calidad mínima o umbral para que el estudio se incluya. Aunque existen algunas dudas al respecto, los estudios con sesgos no deben ser incluidos y ayuda a disminuir la heterogeneidad entre estudios. Esto se apoya también en el hecho de que los estudios metodológicamente más pobres tienen tendencia a obtener resultados más significativos. Hay que ser muy cuidadoso en la exclusión de estudios, puesto que puede introducir un sesgo de selección si los criterios utilizados no son objetivos y sugestivos de que indican la «verdad». Seleccionar en función de la calidad puede introducir un sesgo de selección. Por ello, el proceso de aceptación/rechazo tiene que estar enmascarado frente a las variables que luego puedan tener repercusión en la combinación final de las evidencias. Esta función cualitativa del cuestionario permite detectar los errores más frecuentes en el tema que vaya a estudiarse y proporcionar recomendaciones para futuros estudios.

El cuestionario de calidad permite la extracción de información referente a las características del diseño. Estos datos pueden utilizarse luego con la finalidad de justificar la heterogeneidad que se encuentre entre las distintas estimaciones individuales del efecto.

La calidad se puede medir de forma continua (mínimo de 0 y máximo de 1 o 100%) y este valor puede tener otros usos. No se recomienda que se incorpore como criterio de ponderación, aunque pudiera parecer lógico, al dar un mayor peso a las investigaciones más correctas. Antes que poner un punto de corte numérico en la escala para determinar la aceptabilidad de un estudio, es preferible que cualitativamente se establezcan las condiciones que debe reunir para ser incluido. La puntuación de calidad se puede usar para hacer un metaanálisis acumulado.

Metaanálisis: métodos de combinación

Se pueden combinar los resultados publicados por los autores o combinar las bases de datos. En este último, el análisis estadístico es convencional, salvo que es conveniente incluir en los modelos multivariables una variable que identifique el número de estudio. Este apartado se dedicará a la combinación de datos procedentes de informes publicados o proporcionados por los autores.

La aplicación de técnicas estadísticas al metaanálisis genera varios problemas que merecen una atención especial:

- Se puede asumir que el efecto producido por la exposición sea constante de estudio en estudio (modelo de efectos fijos) o, por el contrario, tenga una distribución al azar a lo largo de los distintos estudios (modelo de efectos aleatorios).

- La elección del modelo usado para expresar la medida de asociación entre la exposición y el efecto tiene repercusión sobre el valor global de significación. Esto ha motivado la realización de un análisis de sensibilidad: repetición del análisis con otros modelos y probar la fortaleza de las conclusiones alcanzadas.

- Todos los estudios incluidos en un metaanálisis no son formalmente «independientes» ya que los últimos pueden iniciarse tras conocer los resultados de los primeros. Esto sí es un auténtico problema: la investigación actual se apoya en la del pasado.

- Existe una tendencia a encontrar resultados estadísticamente significativos conforme el número de estudios aumenta, aunque no favorezcan la asociación. Por ello, algunos autores recomiendan que a la hora de calcular un intervalo de confianza (IC) o considerar como relevante un resultado, se aumente el nivel de significación (mínimo del 1%). No obstante, la mayoría de los metaanálisis publicados trabajan con IC del 95%.

Sea cual sea el procedimiento que se aplique, cada estudio proporcionará el mismo parámetro (θi), que luego se combinarán utilizando un criterio de ponderación, wi:θp = (Σ wiθi)/Σwi.

Métodos para variables dicotómicas: modelo multiplicativo

Son métodos que se basan en la noción de riesgo relativo (RR). Este modelo es generalmente más adecuado que el aditivo para las relaciones entre una exposición y un efecto.

Se explicará el método del inverso de varianza. En el caso de que se prefiera aplicar un modelo aditivo, basado en la diferencia de riesgos, se puede aplicar también el método del inverso de varianza que a continuación se describe.

Método del inverso de varianza

Se usa como criterio de ponderación en el cálculo del parámetro resumen el inverso de varianza. Las ecuaciones expuestas a continuación se basan en la odds ratio (OR), pero es el mismo para el RR. Para la combinación de resultados, dado que la OR no sigue una distribución normal, se utilizará la transformación logarítmica. El peso de cada OR será dado en función del inverso de su varianza:

$$ln\ OR_{p} = \frac{\sum w_{i} \times ln\ OR_{i}}{\sum w_{i}}$$

siendo

$$w_{i} = \frac{1}{V \left (ln\ OR \right )}$$

donde ORp es la odds ratio ponderada. Para calcularlo será necesario realizar la transformación antilogarítmica. Cada estudio, por lo tanto, debe proporcionar una OR y su varianza. La forma de estimar los parámetros crudos se encuentra resumida en la tabla 17-3, basándose en la distribución de la tabla 17-2.

En el caso de que se ofrezcan estimaciones ajustadas (controlando por uno o más factores de confusión), los autores suelen proporcionar el IC de la OR. En esta situación, para calcular la varianza de la OR, se aplicará la ecuación siguiente:

$$V \left (ln\ OR \right ) = \left [\frac{\left (ln\ OR_{s} - ln\ OR_{i}\right )}{3,92} \right ]^{2}$$

donde ORs y ORi son los límites superior e inferior del IC de la OR. El valor 3,92 resulta de multiplicar por 2 el valor de la distribución normal para un error alfa del 5%, 1,96.

La varianza del logaritmo natural de la ORp es igual al inverso de la suma de los pesos de cada OR, V(ln ORp) = 1/(Σ wi). El IC de la ORp es = ORp ⋅ EXP [± zα/2 √V (ln ORp)], donde zα/2 = 1,96 si se quiere una confianza del 95%.

La significación global del parámetro (para comprobar si la OR es diferente de la unidad) se puede estimar dividiendo el logaritmo natural de la ORp por su error estándar, χasoc = ln ORp/√[V(ln ORp)], que sigue una distribución normal (0,1).

El grado de homogeneidad se valora mediante el estadístico Q = Σ wi(ln ORi – ln ORp)², que sigue una distribución χ² con (k - 1) grados de libertad, donde k es el número de estudios. El punto de corte para detectar heterogeneidad se sitúa en el 10% (p = 0,1) y no en el clásico 5%.

Se puede incorporar explícitamente la variabilidad entre estudios, por diferencias en los protocolos, períodos de seguimiento, etc. Esto es, asumir un modelo de efectos aleatorios, en vez de fijos, como hasta ahora se ha hecho. Hay que calcular la varianza entre estudios:

$$τ^{2} = máx\ \left (0, \frac{Q - K + 1}{\sum w_{i} - \left (\frac{\sum w^{2}{i}} {\sum w{i}} \right )} \right )$$

El peso de cada investigación vendría dado ahora por:

w*i = 1/(Vi + τ²). Esto supondría que la OR*p = Σ(w*i ORi)/Σ w*i. La varianza y el intervalo de confianza se estiman como en el caso anterior, cuando no se tuvo en cuenta la variabilidad entre estudios. En el presente caso se sustituiría wi por w*i. El resto del procedimiento es igual.

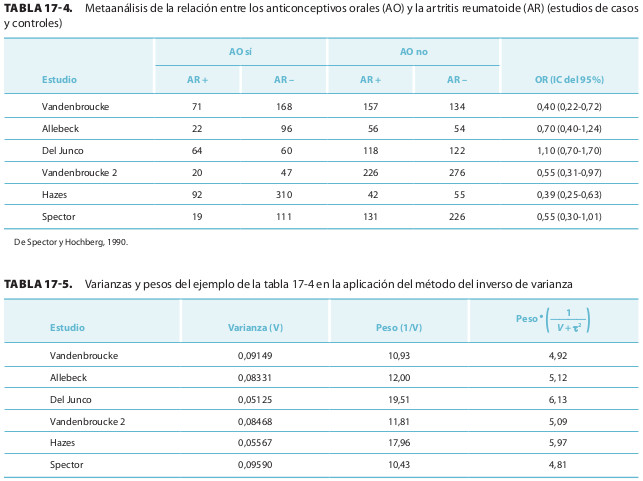

El procedimiento anterior se ilustra con un ejemplo. En un metaanálisis sobre el efecto de los anticonceptivos orales (AO) en el riesgo de artritis reumatoide (AR) se recogieron seis estudios de casos y controles (tabla 17-4).

Hay que calcular la varianza de cada estudio. Se dan en cada estudio los límites de la OR. Para el estudio de Vandenbroucke sería [(ln 0,72 – ln 0,20) / 3,92]² = 0,09149.

En la tabla 17-5 se resumen las varianzas de cada estudio, sus pesos, y los nuevos pesos tras la comprobación de que τ² = 0,11187. La ORp, su IC y la Q valen:

$$ln\ OR_{p} = \frac{10,93 \times ln\ 0,4 + … + 10,43 \times ln\ 0,55}{10,93 + … + 10,43} = -0,51$$

$$OR_{p} = e^{-0,51} = 0,60$$

$$V \left (ln\ OR_{p} \right ) = \frac{}{10,93 + … + 10,43} = 0,0121$$

$$IC\ 95\% OR = 0,60 \times e^{\pm 1,96 \sqrt{0,0121}} = 0,48 a 0,74$$

Q = 10,93 (ln 0,4 - ln 0,60)² + … + 10,43 (ln 0,55 - ln 0,60)² = 12,75

con 5 grados de libertad, p = 0,026 (hay heterogeneidad entre los estudios).

Como ya se ha mencionado, τ² > 0 y se puede aplicar el modelo de efectos aleatorios. Se recalculan los pesos (tabla 17-5) y se comprueba que las diferencias en la importancia de los estudios se han amortiguado: con los pesos originales el estudio de Del Junco casi duplicaba el peso del de Spector (19,51 frente a 10,43), mientras que con la nueva ponderación son más parecidos (6,13 frente a 4,81). Con el modelo de efectos aleatorios se concede una mayor importancia relativa a los estudios más pequeños.

Con el modelo de efectos aleatorios, la ORp = 0,58 y un IC estadísticamente significativo (0,41-0,83), aunque más amplio que en el caso anterior. Al aumentar la variabilidad de los estudios (se hace mayor su varianza), la χ²h es menor, 4,28, con 8 grados de libertad, p = 0,369.

Estrategia general de análisis

La elección entre una medida basada en el RR o en la diferencia de riesgos (DR) depende de los objetivos de la investigación. La utilización del método del inverso de varianza en los diseños de observación (cohortes, casos y controles) posibilita que los parámetros que se ponderan puedan estar ajustados por factores de confusión.

Con respecto a la disyuntiva de utilizar el modelo de efectos fijos o aleatorios, se insiste en que la elección debe especificarse antes y no tras conocer los resultados. Es muy común empezar por un modelo de efectos fijos (mucho más restrictivo a la hora de considerar la heterogeneidad, ya que es más fácil detectarla con este procedimiento) y esto basta si no hay heterogeneidad; por el contrario, si hay heterogeneidad, se recurre al modelo de efectos aleatorios. A priori se recomienda el de efectos aleatorios cuando el número de estudios es pequeño (<20). Este modelo asume que se tiene una muestra de los estudios existentes, asunción más realista que tener todo el universo de estudios, como subyace en el de efectos fijos. No obstante, conviene saber que la estimación ponderada procedente de un modelo de efectos aleatorios no tiene interpretación poblacional, ya que la distribución de error aleatorio de muestra no tiene justificación biológica o epidemiológica (un grave inconveniente). El modelo de efectos aleatorios introduce un término de variabilidad adicional y aumenta la varianza del estimador resumen, con un mayor IC. Esto no es una ventaja desdeñable, ya que uno de los inconvenientes que se han señalado en el metaanálisis es la facilidad de obtener resultados estadísticamente significativos. Sin embargo, el mismo coeficiente de variabilidad se añade por igual a cada estudio, lo que concede una mayor importancia relativa a los estudios pequeños frente a los grandes, lo que supone que el modelo de efectos aleatorios está más expuesto a la influencia de los errores que afectan a los estudios pequeños, como el sesgo de publicación.

Algunos autores recomiendan que se haga un análisis de sensibilidad, siempre y cuando sea posible. Consiste en combinar los resultados de las distintas investigaciones por más de un método. Si los distintos análisis coinciden, esto reforzará la inferencia que haya que realizar de los resultados.

Métodos para variables continuas

Las variables de efecto continuas se utilizan más raramente en epidemiología, aunque en otros campos son las más frecuentes. Las medias o las diferencias de medias se suelen combinar por el inverso de varianza. Se pueden usar los modelos de regresión, en el que se relaciona el riesgo de enfermar con las dosis-tiempo recibidas.

Metaanálisis acumulado

Consiste en añadir cada vez un estudio en la estimación del parámetro resumen según una variable cuantitativa que permite la ordenación de las distintas investigaciones. Los resultados se presentan en forma de gráfico, representando el valor del estimador resumen (RR, OR, etc) y su IC después de cada adición. El más habitual es el realizado según la fecha de publicación: cada vez se añade un estudio más reciente en el tiempo. Sirve para valorar cuál es la contribución que tiene cada estudio sobre el grado de evidencia disponible en ese momento. Se pueden realizar metaanálisis acumulados según otras variables cuantitativas: calidad global de cada estudio individual, frecuencia del efecto en el grupo de referencia, etc. En este caso se puede analizar la heterogeneidad del resultado en función de la característica por la que se agrupan los estudios.

Estudio de la heterogeneidad

La síntesis de estudios realizados en diferentes lugares (países), tiempos, en diferentes poblaciones y con diferentes diseños produce con frecuencia que los resultados sean estadísticamente diferentes entre sí. Esta heterogeneidad no puede ignorarse. Todo metaanálisis tiene que realizar un análisis de la heterogeneidad. Supóngase que todos y cada uno de los resultados de los estudios individuales es cierto, no está sesgado, y existe una marcada heterogeneidad. En esta situación, el cálculo de un parámetro resumen de los diferentes estudios no aporta nada (más bien todo lo contrario, confunde). El conocimiento de la media entre los diferentes estudios no permite apreciar la riqueza de la variabilidad existente. Lo más acertado en estos casos sería investigar cuáles son las razones que subyacen para que se produzcan resultados contradictorios. El metaanálisis sólo debe sacar un denominador común cuando en verdad éste existe.

Un inconveniente grave del análisis de la heterogeneidad es que la mayoría de las pruebas estadísticas de heterogeneidad no tienen una potencia estadística adecuada; por consiguiente, la demostración de que no hay heterogeneidad no quiere decir que de verdad los estudios que se combinan sean homogéneos. En el análisis de la heterogeneidad se ha de partir de una reflexión de cuáles pueden ser las variables que pueden ejercer una influencia diferencial (características de diseño, otros factores de riesgo, variables de tiempo y lugar, etc.) (tabla 17-6). A continuación, se puede proceder de varias maneras diferentes:

- Análisis estratificado. Se repite el metaanálisis en cada uno de los estratos. Si desaparece la heterogeneidad, es razonable pensar que esa variable influye. El inconveniente que presenta esta estrategia es que puede resultar poco eficiente si el número de estratos es importante y el total de estudios es pequeño. Se puede investigar la heterogeneidad intragrupo mediante el cálculo de una Q de heterogeneidad residual (Qr), que es la diferencia entre la Q global de heterogeneidad y la existente entre grupos.

- Metarregresión. Suele ser más eficiente que la técnica anterior. En ella se utiliza como variable dependiente la magnitud del efecto que se valora con una o varias variables independientes: ln OR = β0 + Σβixi. Las técnicas de metarregresión trabajan con datos agregados y, por lo tanto, están sometidas a los problemas de la falacia ecológica.

- Metaanálisis acumulado. Es menos sensible que las anteriores para la identificación de la heterogeneidad.

- Análisis de influencia. El análisis de la heterogeneidad en ocasiones no revela ninguna causa, sino que parece deberse a un error aleatorio, motivado porque una o varias investigaciones encuentran asociaciones que difieren de la media. Son valores extremos, o outliers, sin ninguna razón aparente. Un análisis de influencia puede ser aconsejable: repetir el análisis con y sin ellos. Si el resultado estadísticamente significativo depende de ellos, hay que ser cauto en la inferencia. También puede cambiarse el peso de esos estudios y comprobar qué sucede con el resultado.

- Análisis de sensibilidad. Puede hacerse de varias maneras:

- con un cambio en los criterios de inclusión de los estudios que se combinan (generalmente características metodológicas), y

- si se han utilizado criterios de corrección de errores, variando los criterios de éstos.

Tabla 17-6. Fuentes de heterogeneidad entre varias investigaciones

Características del diseño de los estudios:

- Tipo de diseño

- Metodología de recogida de la información

- Tipo de análisis empleado

- Control de sesgos

Características de las poblaciones participantes:

- De la exposición

- Del efecto

- De modificadores de la relación exposición-efecto

Sesgo de publicación

El sesgo de selección es difícilmente controlable (normalmente no) en el análisis. El sesgo de publicación es el primer origen del sesgo de selección en el metaanálisis; no en vano, la mayoría de los metaanálisis se realizan sobre estudios publicados. Es necesario cuantificar de alguna manera la posible existencia de este sesgo. Existen varios procedimientos para ello:

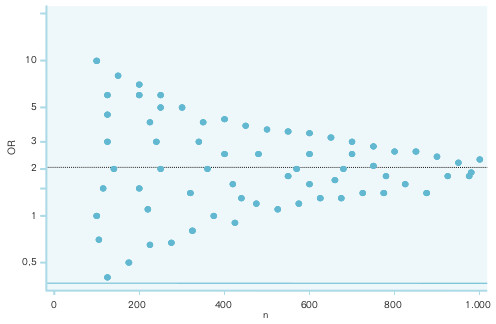

- Representación del logaritmo natural del RR frente al error estándar. Si se coloca el ln RR en el eje de ordenadas, se obtendrá la imagen de un embudo, con la parte más estrecha dirigida a la izquierda (más precisión cuando el error estándar es pequeño). La existencia de una figura simétrica alrededor de un eje que pasa por el valor ponderado del RR habla en favor de la ausencia de este error. Cuando se coloca el ln RR en el eje de abscisas, en el eje de ordenadas se suele representar el inverso del error estándar o el peso del estudio, para obtener una imagen similar a un árbol de Navidad.

- Representación del ln RR y su IC frente al tamaño de muestra del estudio, en esta situación el embudo es más estrecho por la parte derecha. La interpretación es similar al anterior. En la figura 17-1 se representa una imagen simétrica, que sugiere la ausencia del sesgo.

- Cálculo del número probable de estudios no publicados: requieren asunciones más o menos subjetivas en su aplicación. Todos los procedimientos sólo tienen en cuenta un factor como responsable de la no publicación (lo que no es cierto): la ausencia de significación estadística en los resultados. Se puede estimar el número de estudios con resultados no significativos que se necesitarían para hacer que una asociación global significativa se hiciera no significativa estadísticamente (método de Rosenthal). También se pueden aplicar estrategias de remuestreo asumiendo que los estudios encontrados con resultado no significativo son una muestra representativa de todos los que se han hecho (publicados o no).

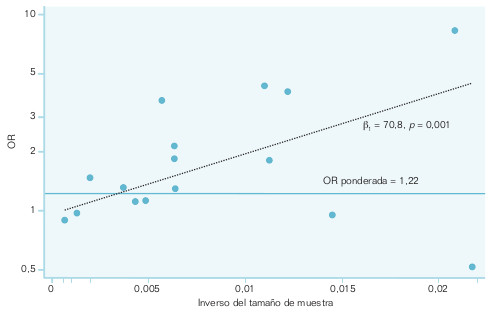

- Métodos de regresión. El más recomendado en la actualidad es la regresión sobre el gráfico en embudo. Se toma como variable dependiente el logaritmo neperiano de la OR, y como dependiente, el inverso del tamaño de muestra. La regresión se pondera por el inverso de la varianza del efecto global observado en cada estudio individual. Lo que se investiga en este procedimiento es si la pendiente de la recta de regresión es distinta de 0 o no. Cuando el valor p de la pendiente es estadísticamente significativo, indica la presencia de sesgo de publicación. En la figura 17-2 se representa un metaanálisis sobre el polimorfismo de la enzima de conversión de la angiotensina y la reestenosis coronaria, en el que se aprecia la existencia del sesgo.

Significación sanitaria de la revisión sistemática

La revisión sistemática ha supuesto una serie de cambios en el terreno científico. Las revisiones tradicionales narrativas sobre un tema incorporan cada vez más las características de sistematicidad del metaanálisis, con consulta a un repertorio bibliográfico informatizado y con más discusión de la metodología de los estudios. Si en un tema hay polémica, el metaanálisis es una alternativa razonable para ver la contribución que tendría un nuevo estudio y las características que debería reunir. El metaanálisis no es una estrategia cara y sus conclusiones pueden ayudar. Contribuye a la toma de decisiones sobre la asociación entre una exposición y un efecto:

- si en un metaanálisis de varios estudios, de los que al menos uno alcanzó significación estadística, se obtiene un resultado estadísticamente significativo, el metaanálisis fortalece el resultado;

- si un metaanálisis de varios estudios, de los que ninguno alcanzó significación estadística, obtiene un resultado estadísticamente significativo, no es recomendable actuar por ese resultado, no es prudente concluir algo significativo cuando no se observa nada claro en las unidades que la componen, y

- si en un metaanálisis en el que al menos un estudio mostró significación estadística se alcanza un resultado no significativo, habrá que reconsiderar los criterios de selección de los distintos estudios o realizar nuevos.

El metaanálisis ayuda a la enseñanza. La comprobación de que los resultados de distintas investigaciones no coinciden, apreciar que ciertas características metodológicas se asocian con el resultado, conocer que los resultados que aparecen en la bibliografía científica pueden estar sometidos al sesgo de publicación, etc, tiene consecuencias muy útiles para enseñar el método científico y sus limitaciones.

Lo primero que hay que comprobar en un metaanálisis que alcanza una asociación significativa es la relevancia de sus conclusiones. El resultado final puede ser pobre, a pesar de alcanzar significación estadística, si el efecto global es de baja magnitud. Suponga que se encuentra un RR de 1,06, con un IC que no incluye la unidad. Un incremento del 6% puede deberse a errores residuales (ej. confusión residual, que puede justificar hasta un 20%). Si hay heterogeneidad entre los diferentes estudios, no se pueden sacar conclusiones globales (peras y manzanas no se promedian).

Las preguntas básicas que debe responder la metodología de un metaanálisis, antes de plantearse la aplicación de sus resultados, se resumen en la tabla 17-7.

Tabla 17-7. Directrices para la valoración de revisiones de artículos publicados:

- ¿Están claramente establecidos los objetivos y métodos?

- ¿Se utilizaron métodos de búsqueda completos para localizar los estudios relevantes?

- ¿Se detallaron los métodos para determinar los artículos que se incluyeron en la revisión?

- ¿Se valoró la validez de los estudios primarios? (análisis de la calidad)

- ¿Fue reproducible y estuvo libre de sesgos la valoración de los estudios primarios?

- ¿Se analizó la variación en los hallazgos de los estudios relevantes? (análisis de la heterogeneidad)

- ¿Se combinaron apropiadamente los hallazgos de los estudios primarios?

- ¿Se sustentaron las conclusiones de los revisores por las evidencias citadas?

La evaluación de los metaanálisis puede hacerse por los protocolos QUOROM, cuando se combinan estudios experimentales, y MOOSE, para los estudios de observación, disponibles en internet ( http://www.consort-statement.org/). Es necesario dejar claro que el metaanálisis es tan válido como lo son los diferentes estudios que se combinan. Es imposible inferir nada si los estudios incluidos en el análisis adolecen de graves deficiencias. Aunque todos los estudios que se incluyan en un metaanálisis sean absolutamente válidos, la inferencia puede presentar problemas (aunque no haya heterogeneidad). Hay que asegurarse de que los distintos estudios que se combinan pueden resumirse en un solo parámetro.